深度学习week4_2

版权申明:本文为原创文章,转载请注明原文出处

深度学习week4_2

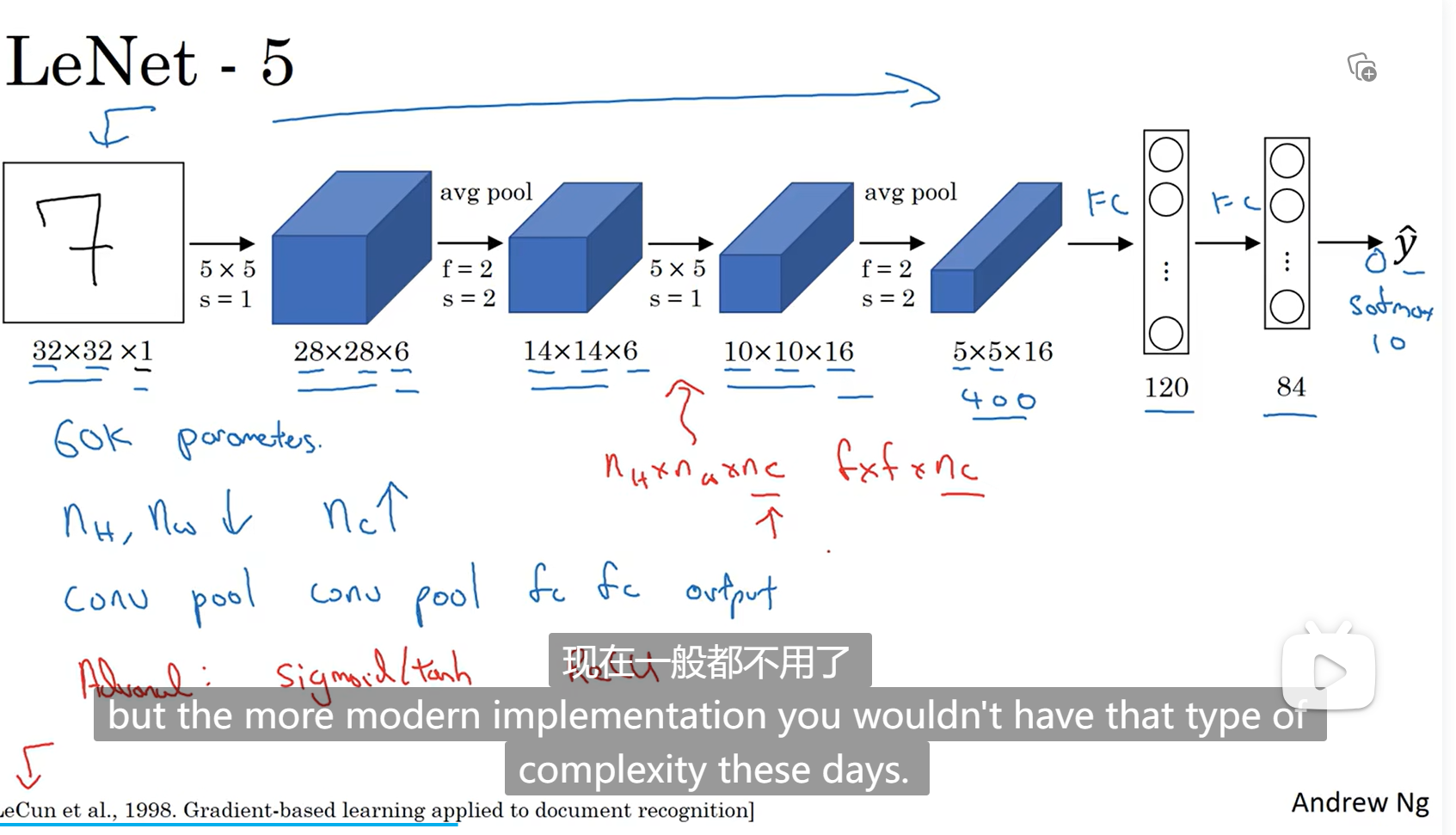

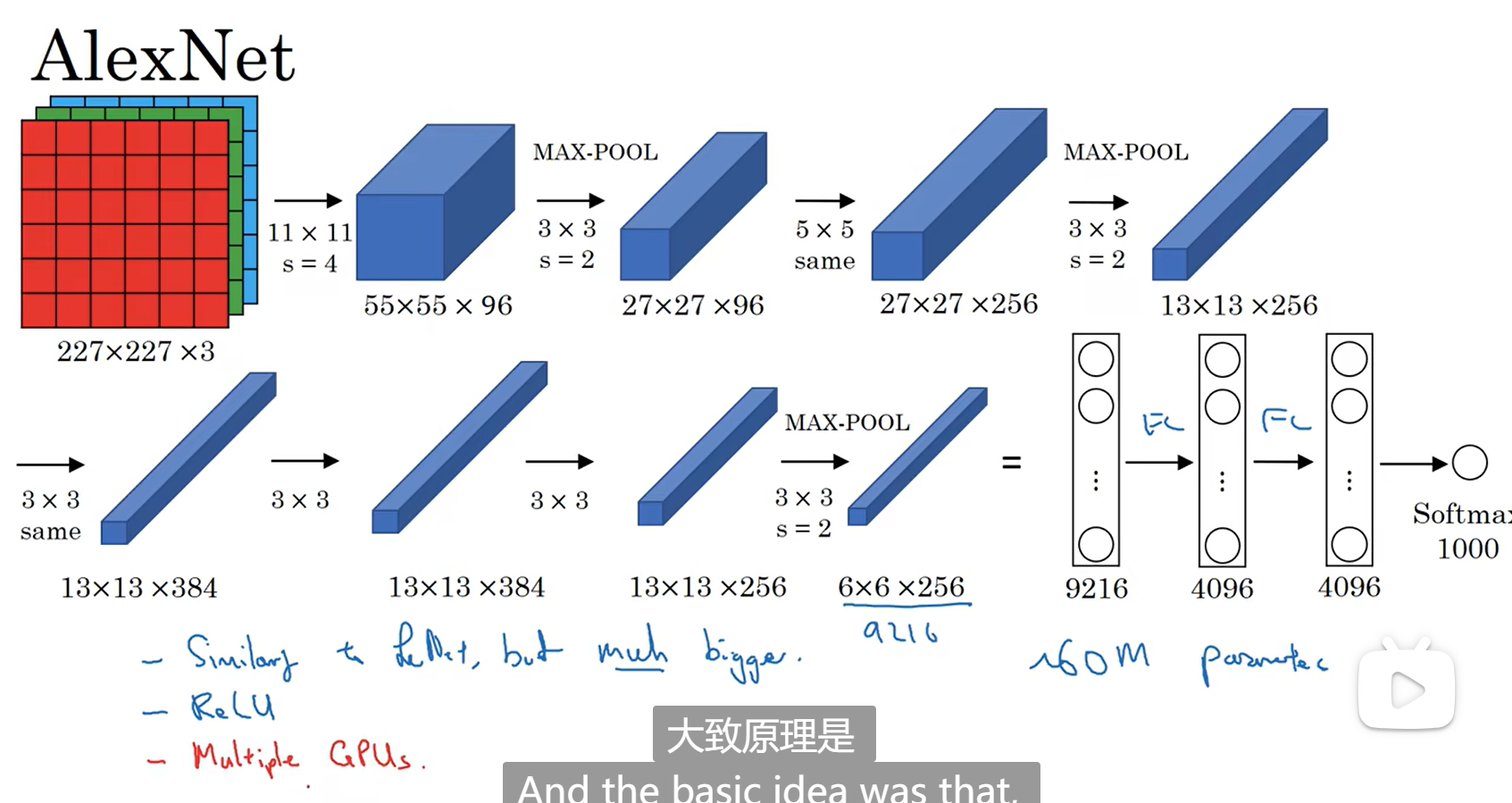

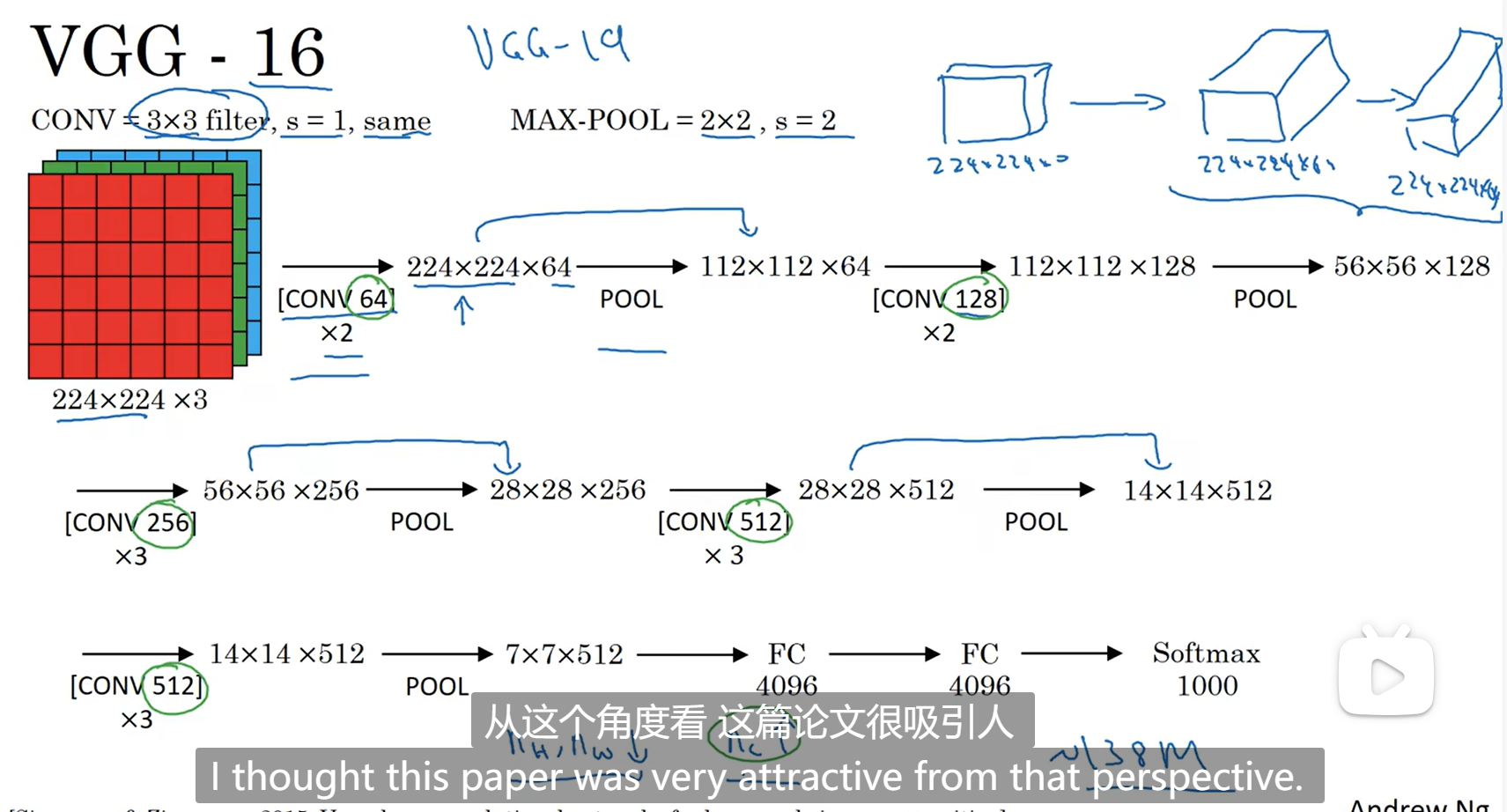

经典网络

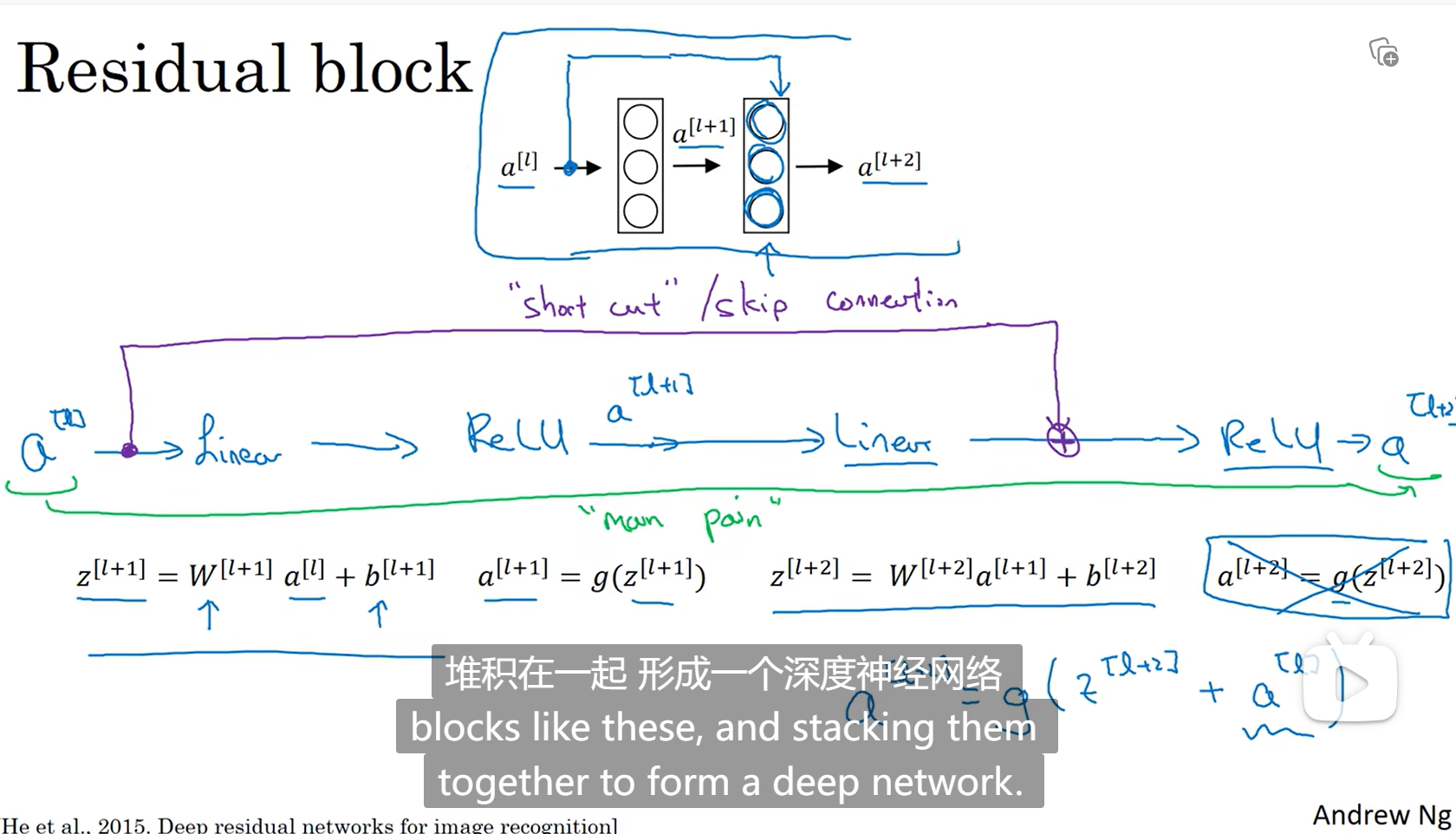

残差网络

Resnet

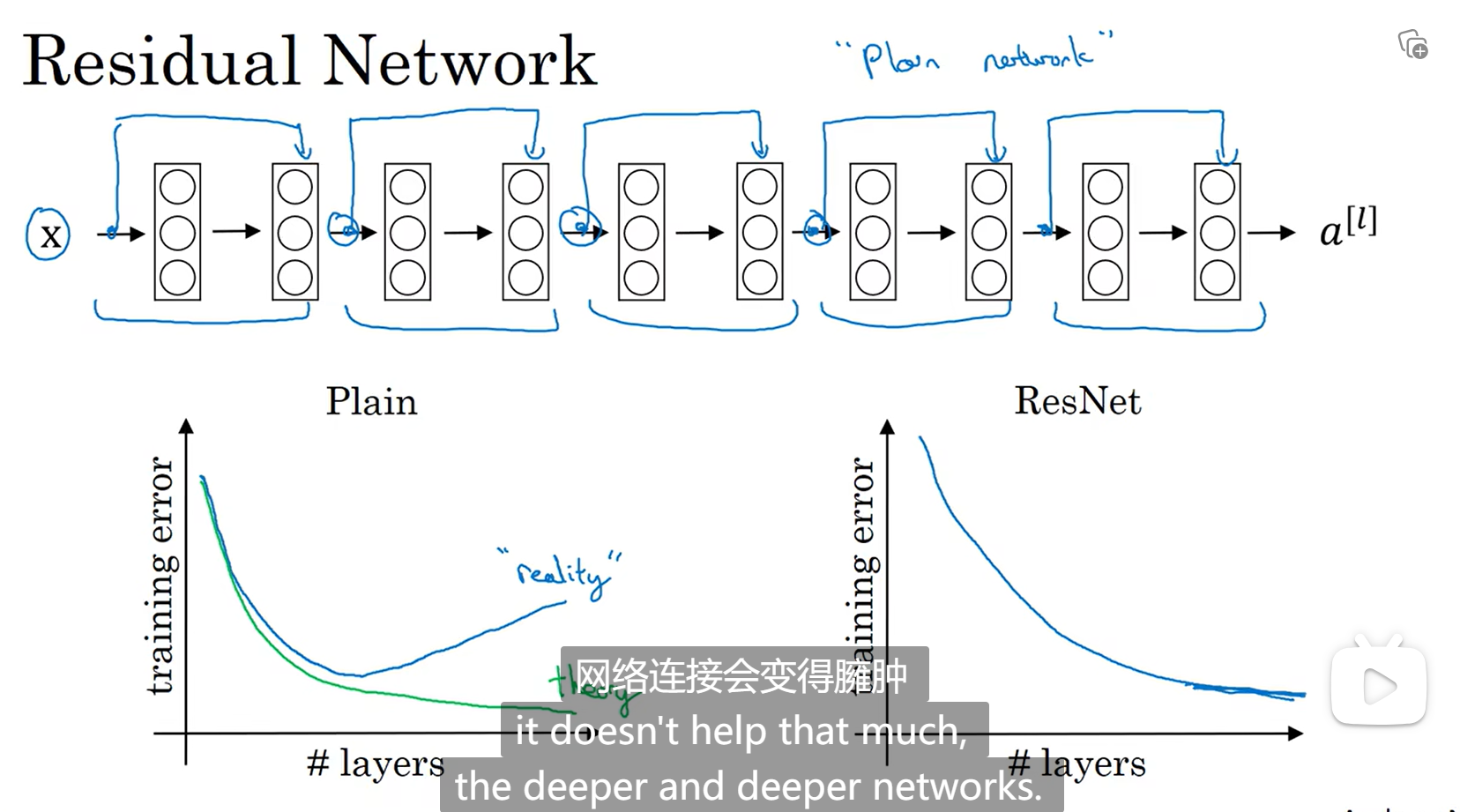

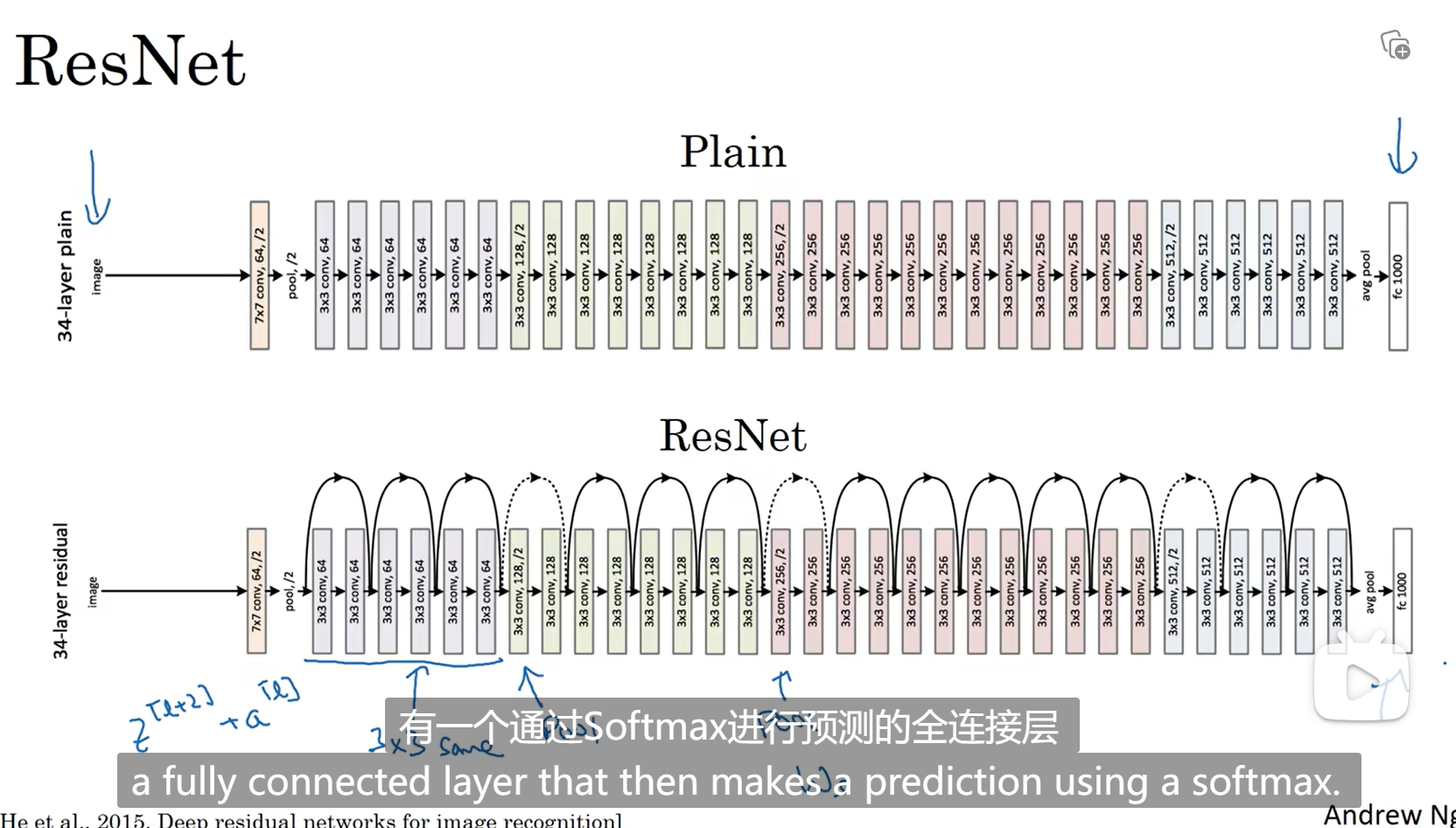

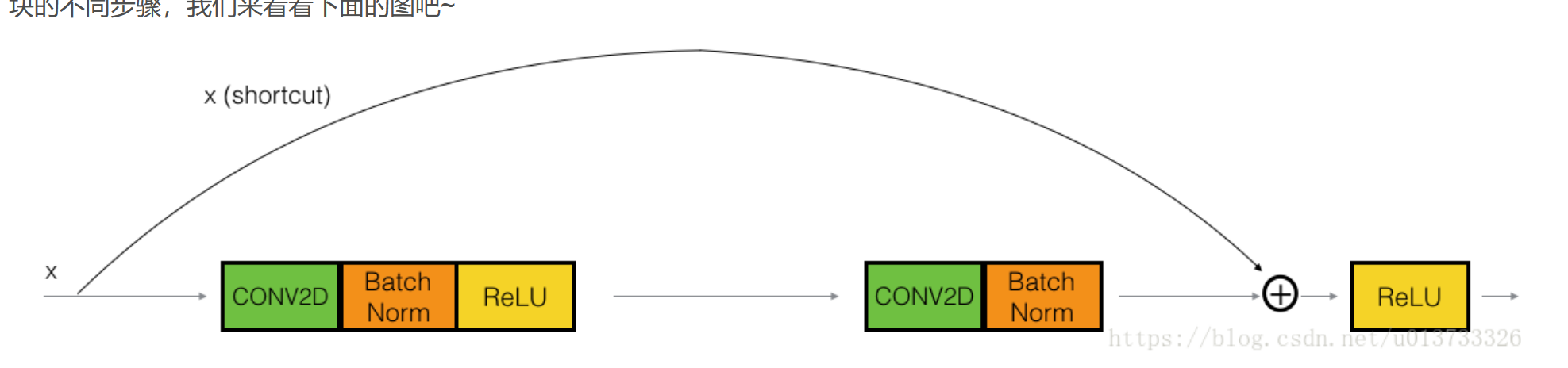

非常深的网络是非常难以训练的,因为存在梯度消失和梯度爆炸

远跳连接:可从某一层网络层获取激活,然后迅速地反馈给另一层

a[i]插在另一层线性激活之后,relu之前的位置:

普通神经网络理想状态:左边的绿线 实际状态:左边的蓝线

添加了残差网络的神经网络:右边

残差网络为什么有用

残差学习恒等函数很有用,性能好

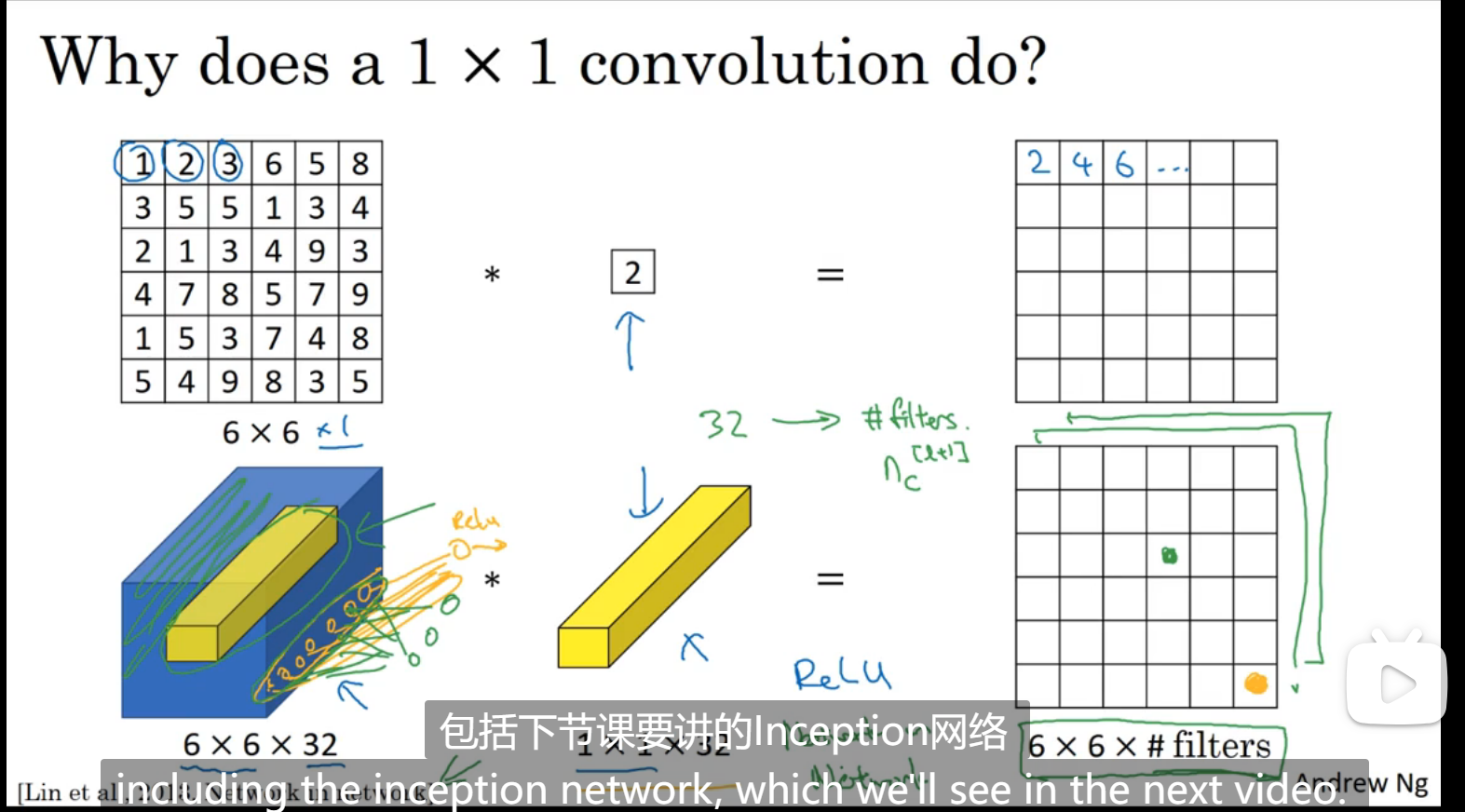

网络中的网络以及1 * 1卷积

上面的相当于二维的每个元素乘以2

下面的相当于是将高确定,宽确定,一整个信道通过乘以适当权重组成一个新的值,最终形成一个二维平面,和1全连接概念有类似部分

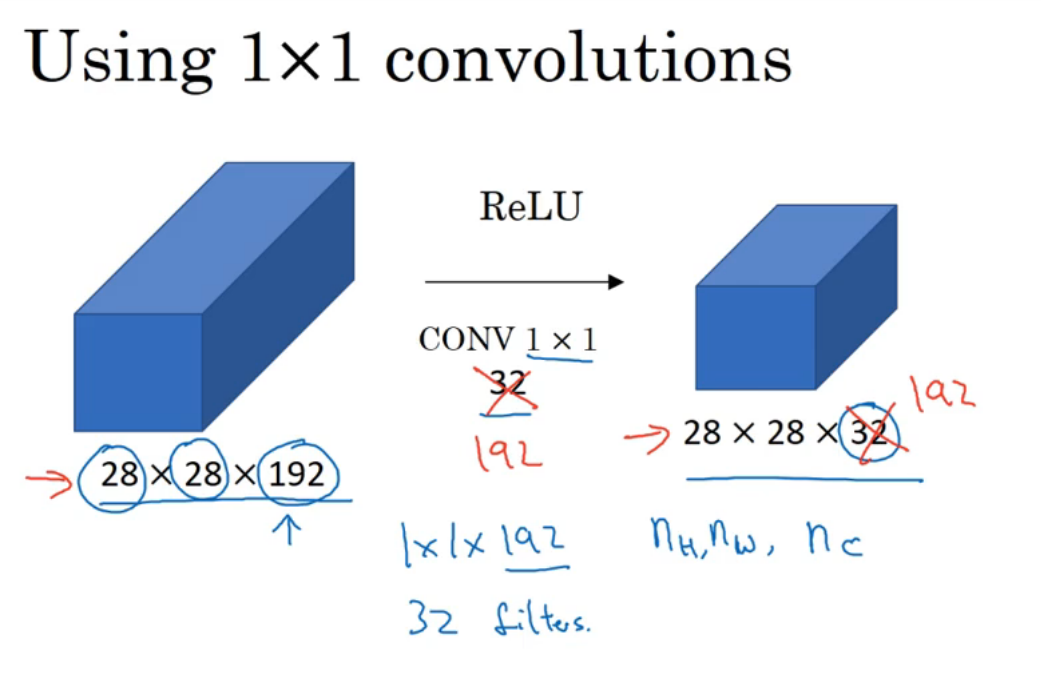

在想要减少信道数量的时候很有用:

谷歌inception网络简介

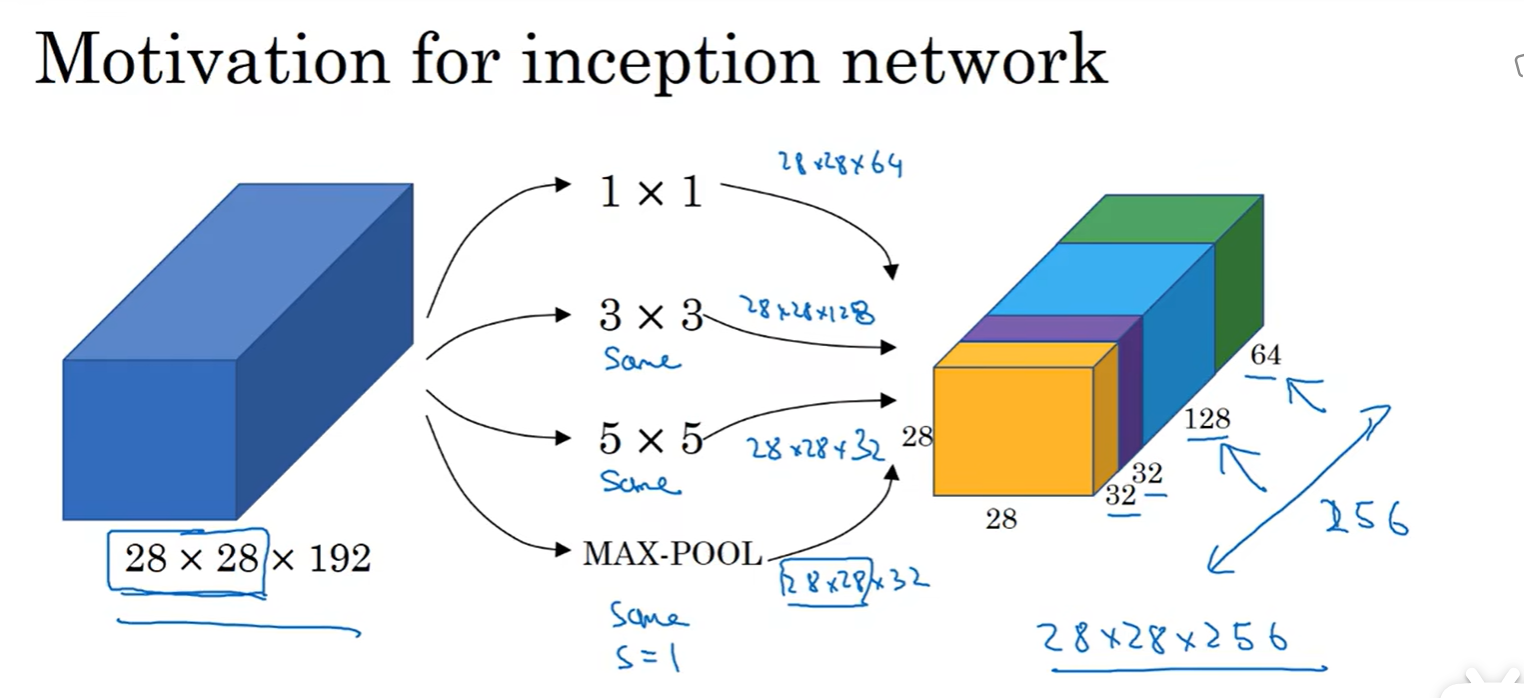

基本思想是inception网络不需要认为决定使用哪个过滤器,或是否需要池化,而是由网络自行确定这些参数

可以给网络添加这些参数的所有可能的值,由网络自己去学习,比如下图,在一层中使用了多种卷积,有1 * 1过滤器,3 * 3过滤器,但是由于padding为same,代表输出和输入维度是一样的,对输入进行填充,最后将所有过滤器的内容排起来,作为下一层的输入

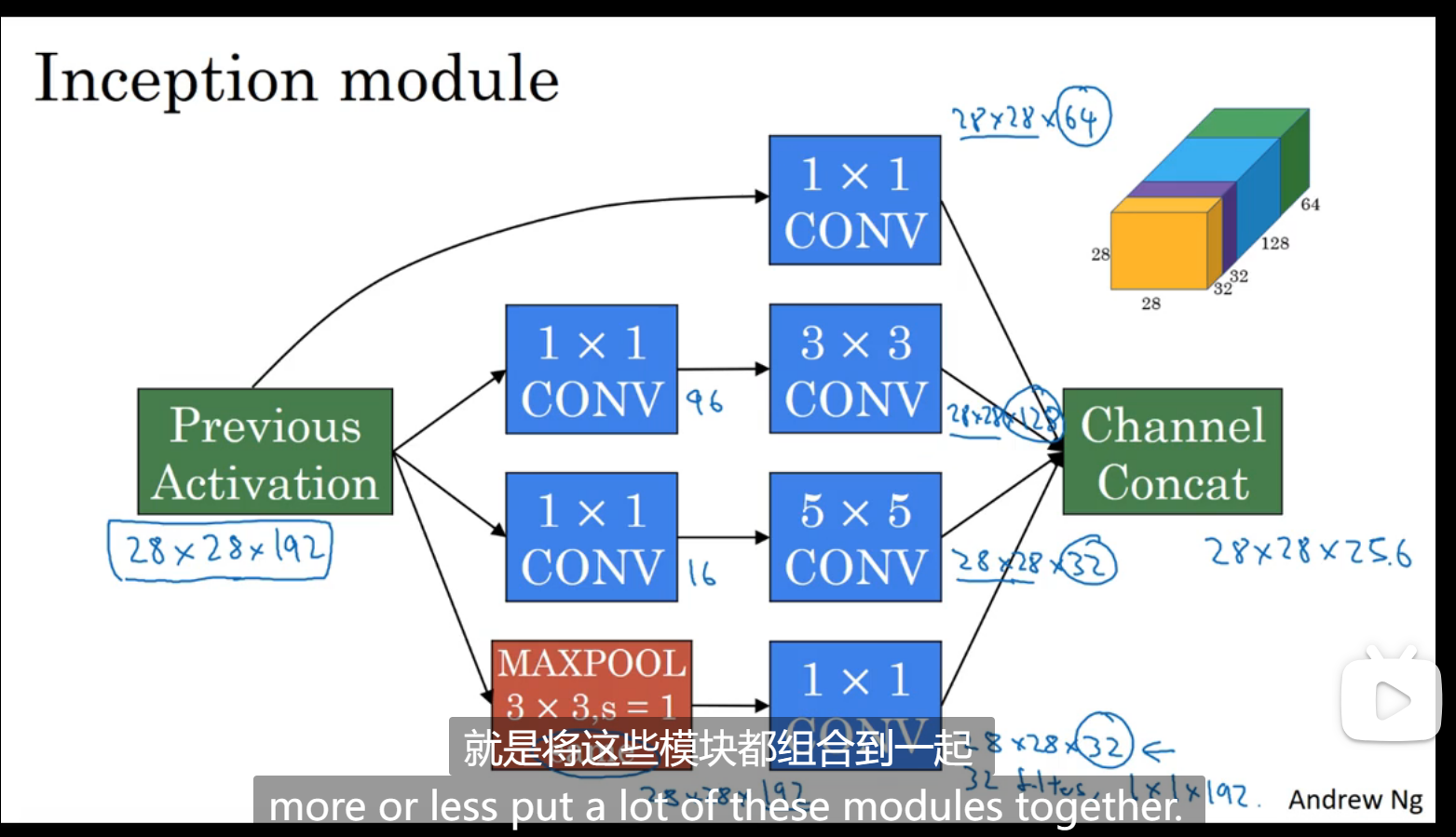

但是直接将一个维度很大的变量压缩成一个维度很小的变量,这样的计算成本很大,因为每个点都需要计算很多次,可以先用1 * 1卷积训练乘以一个维度较小的变量,再将其扩大,这个维度较小的变量叫做瓶颈,合理利用瓶颈可以提高计算效率

inception网络

如图所示,和上节讲的一致,一层不止用一种卷积,同时对于大维度的变量,先压缩成瓶颈再扩大,

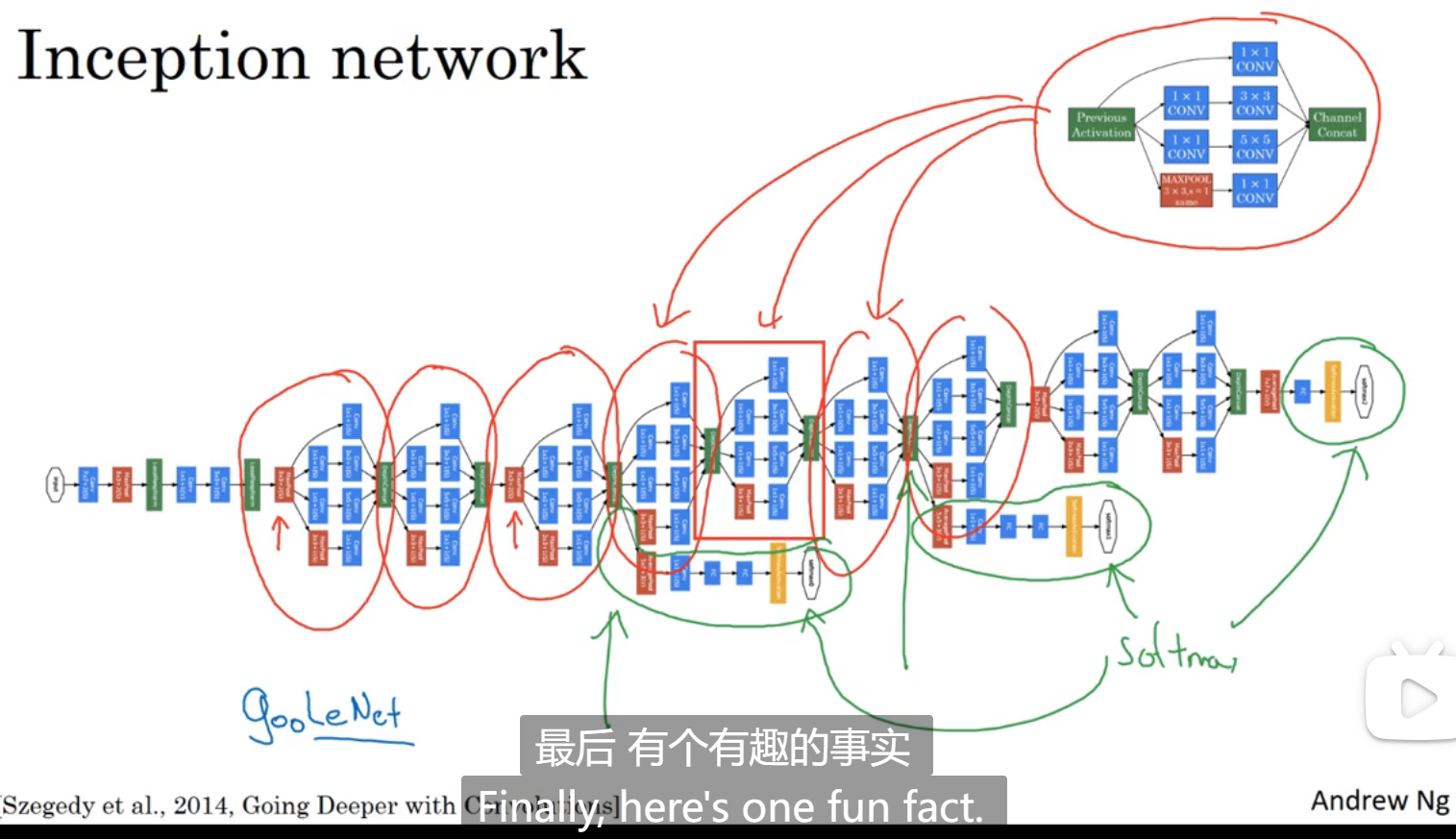

google的inception网络

使用开源的实现方案

编程

恒等块(维度一致):

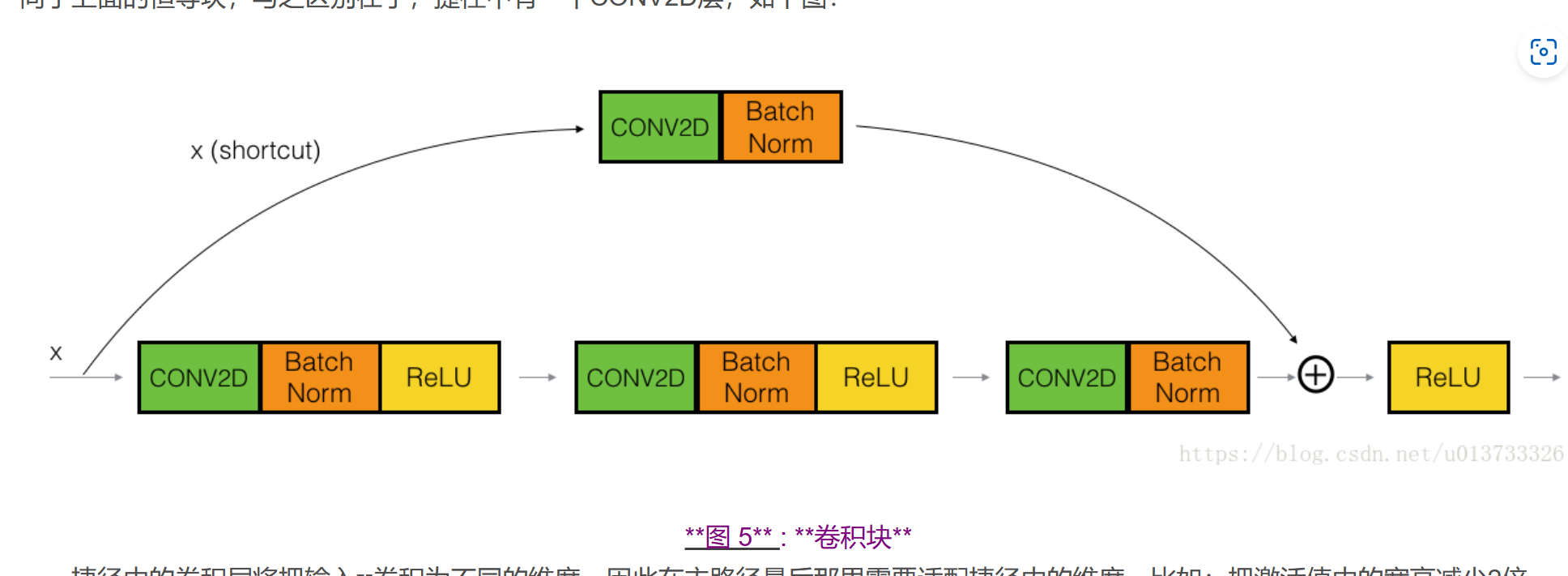

卷积块(维度不一致,需要用卷积调整维度):

深度学习week4_2

You need to set

install_url to use ShareThis. Please set it in _config.yml.